思い違い・思い込み・見落とし

いきなりですが、二人が会話するユダヤの小話を。

A「知恵と金では、どちらが大切だろう」 B「もちろん、知恵に決まっているさ」 A「それなら、どうして賢人が金持ちに仕え、金持ちは賢人に仕えないのだろうか?」 B「簡単さ。賢人は金の有り難みが分かるが、金持ちは知恵の大切さが分からないからだよ」

人の世に失敗は付き物で、知恵者が多そうな金融の世界でも大小さまざまな失敗が繰り返されています。たとえば四半世紀近く前の米ヘッジファンドLTCMの大失敗からは、いろいろ気付かされます。まず、ノーベル賞受賞者等ドリームチームの自信過剰の「思い違い」、然るべきデータ分析さえすれば良いモデルができるという「思い込み」、さらに流動性リスクの「見落とし」など、投資家ジョージ・ソロスも強調(日経ビジネス記事2010.5.10「ソロス氏が読み解く危機の歴史」)するように、人間の前提条件は間違うことと認識すべきでしょう。以下では茶飲み話的に、ありがちな間違いなどの周辺を緩めになぞってみたいと思います。

偶然に関わることでは、もうそろそろ、まだまだ、など色々思い違いがありそうです。たとえば、ふつうにコインを5回投げて5回とも「表」だったら、そろそろ次は「裏」だろうと思いがちでしょう。それでも「ギャンブラー」を自任する人ならば「流れが傾いている」として、次も「表」と思うかもしれません。確率論的には、どちらも「思い違い」ですが、ふつうの人は冷静に偶然と向き合うことができず、したがってカジノが繁盛することに。

さらに、数字の世界は思い違いが起きやすいと言えそうです。新型コロナ・ショックで経済に大きなダメージがありましたが、その回復を比率で見るようなときには注意が必要です。仮にGDPが30%ダウンした後、30%戻しても元通りの水準ではないですね(元の水準を100とすれば、70に落ちてから1.3を掛けても、91(=70×1.3)です)。同様に、50%ダウンした後、90%アップしても元の水準の95%にしかなりません。

とにかく人は間違いやすいと自戒すべきでしょうが、不確かな将来の話になると、それが思い違いなのかどうか分かりにくくなります。かつて20世紀末に目前の「2000年問題」が大騒ぎになりました。1999年から2000年になるときに世界のコンピュータシステムの機能停止・誤作動で混乱が生じる恐れ(日付データで西暦年の上2桁を省略していると2000年が1900年と見なされる等)が指摘され、格好のニュース種になりました。混乱回避の努力もあって、結局大したことなく新年を迎えましたが、直前まで、対策漏れ/思わぬ所でのリスクの心配など、終わってみれば一種の思い違いだったと言えるかもしれません。

人が作ったコンピュータ(システム)も「思い違い」からは逃れられず、ソフトウェアにバグがあってコンピュータが処理を間違うことは珍しくありません。「いかに人は間違いやすいか」を自覚させることを、いまのプログラミング学習の目的としても良いのではと思うほどです。ただし、処理が高度なアルゴリズムによって行われていると、不具合に気付きにくいことがあります。(アルゴリズムとは「特定の問題を解いたり、計算処理を行うための一連の手順」:Wikipedia)

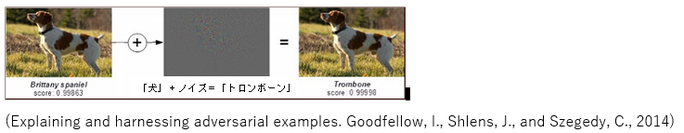

高度なアルゴリズムに基づく人工知能(AI)は、画像認識の精度が飛躍的に向上し、ビジネスなどで活用が進んでいますが、「思い違い」からは逃れられないようです。一般に、AIによる画像認識は人間と同等以上の性能があると言われますが、ある種のノイズを付加された画像は、人の目には同じように見えても、AIには全く異なる画像に見える、という問題(たとえば下図で「犬」を「トロンボーン」と誤認識)が指摘されています。

この「思い違い」はバグではなく、AIが画像の「形」でなく「テクスチャー(風合い)」を見ていることに起因するようで、一種のAIのクセとも言えそうです。したがって、クリティカルな用途(たとえば車の自動運転)でAIを使う場合には、細心の注意が必要です。

このように思い違いもするAIと付き合うためには、AIの動作を分かる必要がありますが、著名な専門家キャシー・オニールは「考え方はシンプル」と言います。(朝日新聞インタビュー「AIのわな」2019.11.7)「成果に導くパターンをデータ分析によって探すのがAIで、大事なのは、その『成果』を誰が定義するかです。たとえば食事メニューで、私にとっての成果は、息子が野菜をたくさん食べることで、息子にとっての成果は、大好物の甘いチョコクリームをたくさん食べることです。しかしキッチンでの権力は私が握っていて『何をもって成果とするか』を決めます。誰がAIのアルゴリズムを支配しているかが問題」と。

人が思い違いを避けるためには文脈の把握が重要です。(西山佑司他「談話と文脈」岩波書店、1999)いま「明日は来れないよ」と友人からのメッセージがあったとします。これをどう受けとめればよいでしょうか。発言意図の可能性はいくつか考えられ、 ①単純に事実を告知しただけ、 ②現時点で無理と信じていることの伝達、 ③残念に思っていることの告白、などが考えられ、もう少し補足メッセージがほしいところです。また、「無いものはないよ」という発言は、「仕方ない」という補足があれば、探し物がどうしても見つからない場合などと解釈できます。あるいは、前置きが「さあ、いらっしゃい!」であれば、店の呼び込みのケースと解釈でき、文脈把握の重要性は明らかです。さらに、たとえば「車から投げられたボール」という言葉に接したときは、「誰かがボールを車外に投げ、ボールには重力が働くので、何秒後かには地面に落ちる」のような「常識」を働かせるべきですが、現在のAIには、文脈・意味の理解力や常識が欠けていて、「思い違い」は避けられません。

ここで「算数」関連の思い違いを誘う引っかけクイズを・・・

まず恒等式です: 6÷3=8÷4

約数で括ります: 3×(2÷1)=4×(2÷1)

共通項(2÷1)で割ります: 3=4 !?

⇒ 実は、式を約数で括れるのは、足し算、引き算の場合でした!

「?」と引っかかった方は、ある種の思い込みがあったのかもしれません。

知らず知らずの思い込みを注意すべき場合があります。たとえば、同じ質問をすれば国際比較ができるという「思い込み」です。「とても好き/好き/どちらともいえない/嫌い/とても嫌い」のような選択肢で好みの程度を訊く質問に対しては、有力調査会社マクロミルによると、日本人は真ん中寄り、中国ではトップボックス寄り、米国では回答にメリハリをつけようとする傾向があるそうです。よく「日本人の意識は他国に比べて・・・」のような話を聞きますが、多国間の調査結果に接する際には大いに注意が必要ですね。

人の思い込みこそ現実という見方もあります。(アル・ライズ、ジャック・トラウト「マーケティング22の法則」東急エージェンシー出版、1994)同書によれば、客観的な現実は存在せず、マーケティングの過ちのほとんどは、自分たちは現実に根ざした商品戦争を戦っているという思い込みに起因する、と。たとえば日米で日本車の販売順位が異なったりするように、消費者がブランドをどう思うかが決定的で、顧客や見込み客の心の中を変えるのは極めて難しいとも言います。

ではAIにも「思い込み」はあるのでしょうか。AIの良さ加減はその学習対象とするデータ次第でもあり、どのデータをどのように学習するかが問題です。たとえば、ローン審査AIモデルを作成する場合、過去に蓄積された多数の顧客データ(完済・延滞状況などで良/不良に分類済)をAIは分析・学習します。擬人的にみれば、AIモデルには過去データが全てという暗黙の「思い込み」があるとも言えます。過去データは、当時の経済・社会情勢を反映していると同時に、ローン申し込み時に謝絶された見込客が除外されていて、そのような「思い込み」補正の必要もありそうです。

学習データに起因するAIの「思い込み」は、知らず知らずのうちに偏見を内包したり、外部からの攻撃を受ける弱点になったりもします。前者については、学習データで人種や性別などの構成バランスが崩れているとき、意図しない「偏見」を非難されることがあります。後者では、例えばスパムメール検知用AIに大量の偽装データを送り込んで学習させ、スパムメールを検知できないようにする攻撃があり得ます。また数年前、人間と会話するチャットボットが米マイクロソフトから公開されると、複数の悪意ある人間から差別的な発言を教え込まれて学習し、自身でも同様の発言を繰り返すようになったトラブルも。(もちろんAI側の対策は可能ですが、攻防いたちごっこは形を変えて続きそうです。)

AI周りで注意すべき思い込みもあります。それはベンチマークテストでAIの進歩が計れるというものです。実際、AIモデルによる画像認識性能向上の成果(評価テスト上の)がアカデミックな研究として発表され続けていますが、使ってみても実際には進歩が分からないとの指摘があります(コーネル大学の研究者等による2020年の論文「A Metric Learning Reality Check」arXiv:2003.08505)。また、AIの文章読解力が「人間超え」などのセンセーショナルな記事がネット検索で見つかりますが、これは米スタンフォード大学の文章読解ベンチマークのテスト成績が非常に良かったということに過ぎず、表面的にAIが文章の意味を理解したように見えても、真に意味を理解できている訳ではありません。実際のところAIをベンチマークに合わせて点取り虫に仕立てることさえ不可能ではなく、この問題をAI全般について指摘する声もあります。(Eye-catching advances in some AI fields are not real https://www.sciencemag.org/news/2020/05/eye-catching-advances-some-ai-fields-are-not-real)

何事でも慣れてくると思い込みが生じ、つい何かを見落としがちです。たとえば医者の世界でも、多くの症例を経験するほど、診断で直感的なバイアスが出やすく、風邪の症状に隠れている重大疾患を見落とすことなどがあり得ます。このとき、思い込み・直感などに固執したり(アンカリング)、最近の経験や見聞きしたことに引きずられること(利用可能性バイアス)などが起りがちです。とにかく人は間違いやすいものと、心しておきたいですね。

結果的に流動性リスクが軽視され見落とされていたように見える2007~2008年の金融危機では、多くの金融機関が資金流動性リスクに直面しました。これは過去にLTCMが直面した市場流動性リスクとは異なりますが、実際には二種類の流動性リスクが連鎖することもあります。このような流動性リスクが繰り返し見落とされがちなのは、平常時のデータからリスク発生時の状況を推測するのが困難だからでしょう。そのため、適切なシナリオを想定したストレステストが重要と言えます。

理屈で分かっていても見落とされがちなのがサイバーリスクです。その脆弱性が人間には見出しにくいとすれば、対策にAI利用を考えるのは自然な流れですが、AIにも限界はあります。すなわち、過去の大量データを学習したAIは過去のリスク・パターンに似たケースを見つけられても、全く新しいものは検出できません。未知ウイルスを見落とさないように頑張り過ぎると、今度はウイルスでないものを「偽陽性」とする心配があります(たとえば「怪しそうな」プログラム動作からの判断では正当なものをウイルスと誤判定する恐れも)。結局、対策は異なるアプローチの合わせ技などで工夫し続けるしかないようです。

いまは、適性あるタスクでAIに情報を与えれば、見落としなく効率的に処理してくれるでしょう。たとえば、時々刻々の情報を得てAIが経済記事を書くと、別のAIがそのような記事を解析し自動取引システムの入力データにします。AIが文章を書き、AIが文章を読み、AIが取引を進める。このとき「危険なのは、機械の頭が良くなっていくことではない。人間の頭が悪くなっていくこと」と指摘する記事もあります。(AIに文章を書かせてはいけない理由 https://project.nikkeibp.co.jp/idg/atcl/19/00028/090900001/?n_cid=nbpnxt_mled_chm)

AIは、あたかも人が書いたような文章を作ったり(偽ブログ記事の作成など)、短い文章を元にプログラムのソースコードやWebページのレイアウトを生成したりする能力なども誇示されています。ただし、それは「膨大な文章のパターンを丸暗記しているようなもので、学習したパターンに該当する問題は解けるが、それ以外は解けない」とも言われ、推論機能についても能力不足を指摘されています。(最新AI「GPT-3」の威力と弱点 https://xtech.nikkei.com/atcl/nxt/column/18/01428/092300002/?n_cid=nbpnxt_mled_itm)これは現在のAIの限界でしょうが、少し視点を変えて「見落とし」に対処する新たなAIが開発できないものでしょうか。たとえば、シャーロック・ホームズものに出てくる有名な対話「昨夜うちの犬は吠えませんでしたよ」「それが奇妙な出来事です」ができるようなAIが作れないかと。つまり、膨大な文書データをストレートに処理するだけでなく、一種の穴埋め的操作を拡張して、ある文書に含まれるべきなのに見落とされている事項・論点などをAIが指摘できれば、面白いのではないでしょうか。

「見落とさないAI」にも問題はあります。たとえば、あるテーマの1000本の論文のうちに3本だけ異なる報告が含まれていたとします。これをどう見ればよいのでしょうか。この3本は間違っているのか、それとも新たな発見なのか?これは、北野宏明ソニーコンピュータサイエンス研究所所長が指摘する「マイノリティー・レポート(少数者の報告)問題」と言われる難問ですが、そこから飛躍して、同氏は新たな知識・知見を得る道具としてAIを使う「無知からの自由」の革命=「知識革命」も予想しています。(「科学するAI」がもたらす「新しい自由」http://wired.jp/2016/09/20/icf2016_kitano/ )

あらためて、人に起因する間違いは必ず起きるとすれば、それを補うツールとしてもAIが期待されます。思い違い、思い込み、見落としなどを減らすために、AIをどう使いこなせるか。現時点ではAIが進歩したと言っても、それは人間が使える「愚直な」ツールと思うべきでしょう。さしあたり、AIを使いこなすためのリテラシー(AIに何ができて、何ができないのかの理解)が求められそうですが、車の自動運転技術との対比で言うと、いまのAIは運転をサポートする「レベル2」のイメージでしょうか。

さらに上のレベルに進化させるためには、ツールとして信頼できるAIが求められます。いま、人はたいていGPSを信用しますが、現時点でも「人間はロボットを信用し過ぎるところがあるかもしれない」という米国の研究があります。ビル火災を模した実験では、 人々が非常口を無視してロボットの誘導に従うという結果が得られました。状況次第で、ロボットがあるタスクをできるとされれば、そのタスクについて人はロボットを信用するという現実は、AI開発・活用のヒントにもなりそうです。ただし一方で、過大評価があるとすれば、それは過小評価に転じやすいことにも注意すべきでしょう。 (緊急時、人間はロボットを信じすぎる http://itpro.nikkeibp.co.jp/atcl/idg/14/481542/030200206/ )

かつてスティーブ・ジョブズは「人は形にして見せてもらうまで、自分は何が欲しいのかわからないものだ」と言ったそうです。いま「20年から30年後には、確実に人類は機械がつくりだした膨大な新しい知識を後追いするようになる」という意見もあります(北野宏明)。これは、卓見なのか、思い違いなのか、思い込みなのか・・・。今後も、思い違い、思い込み、見落としなどが避けられないとしても、人類は知恵を生かして、致命的なミスを回避し、より良い社会に向かってほしいですね。

塩田千幸